12 самых распространенных ошибок оптимизации сайта.

Оглавление:

Оглавление:

Выполняя аудиты сайтов, я заметил, что владельцы ресурсов часто допускают (или просто не замечают) одни и те же ошибки. Причем это касается и технических моментов, и проблем непосредственно с SEO или контентом.

Поэтому решил написать статью о самых распространенных ошибках при продвижении сайта. Разберем ошибки по типам:

- технические,

- ошибки оптимизации

- косяки с контентом.

А чтобы вам проще читалось, я буду придерживаться одного формата: собственно ошибка, потом краткое описание и способы исправления.

Самые частые технические ошибки в продвижении сайтов:

- Делали новую версию сайта и забыли закрыть ее от индексации.

Казалось бы, ошибка новичка. Но практика показывает, что такое случается сплошь и рядом. Иногда сеошник забудет, иногда разработчик проигнорирует. Смешно? Очень даже… Но последствия серьезны:- Дубли страниц – когда старый контент появляется под новым адресом на тестовой версии и попадает в индекс.

- Мусорные страницы – когда ненужные страницы, которые не удалил вебмастер, попадают в индекс и «размазывают» релевантность нужных урлов (url-адресов) или просто приводят к пометке поисковика о некачественном контенте.

- Важные страницы с мусорным контентом. Это самый печальный исход при подобной ошибке: на важной странице, которая целенаправленно готовится к продвижению, в индекс вместо нужного попадает левый текст (шаблонная заготовка или бессмысленный набор символов, оставшийся с этапа верстки). Потом в ожидании переиндексации таких страниц теряется много времени.

Такие ошибки лучше не допускать, но если уж случилось, то нужно исправлять как можно быстрее. Для профилактики нужно регулярно проверять индекс во всех продвигаемых поисковиках и в их кабинетах.

- Забыли открыть индексацию при переносе, разработке, смене движка (дизайна и т. п.).

Причин может быть много, результат – один: сайт вылетает из индекса. После исправления, как правило, индекс восстанавливается довольно быстро, но вот позиции при этом можно потерять надолго.

Тут все так же, как и в первом примере: лучше не совершать такую оплошность и регулярно мониторить индексацию и посещаемость (т.к. она гарантированно упадет, если сайт вылетит из индекса). - Битые ссылки.

Эта проблема самая распространенная (встречается на 4-х сайтах из 5). Суть в том, что на страницах сайта есть ссылки на несуществующие документы. Это могут быть удаленные картинки, страницы или просто неверные урлы. Объединяет их одно — при переходе выдается код 404.

Поисковики очень не любят такие ошибки и с удовольствием понижают в выдаче те сайты, на которых они встречаются.

Лечатся битые ссылки регулярными проверками специальным софтом. Я использую Screaming Frog SEO Spider или Xenu. Если вы нашли битые ссылки на сайте, исправьте их или удалите.

- Неправильная настройка файла robots.txt.

Очень часто в роботсе либо забывают закрыть лишний мусор, либо наоборот закрывают слишком много.

При составлении роботса я руководствуюсь следующими принципами:- Запрещать только то, что не нужно в индексе. Как правило, это вход в админку, технические дубли, страницы поиска, различные фильтры, служебные страницы и т.п.

- Обязательно проверить доступность для роботов всех разделов сайта.

- Картинки, стили, ява-скрипты должны быть открыты для поисковых роботов. Это особенно актуально для Гугла. И в его же вебмастере можно проверить, какие адреса нужно открыть для индексации, чтобы поисковый бот мог нормально индексировать страницы. Для этого перейдите в раздел «Проверка URL -> Изучить просканированную страницу -> Подробнее» и протестируйте все шаблонные страницы.

- CMS сайта не настроена и создает дубли страниц.

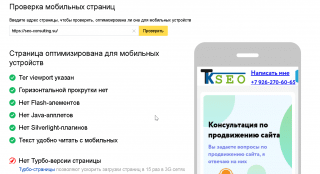

Такая проблема встречается последнее время реже, но, тем не менее, многие проекты грешат этим, особенно старые. Суть в том, что CMS (т.е. движок сайта) делает доступным один и тот же материал по разным url-адресам. В результате в индекс попадают несколько абсолютно одинаковых страниц. А теперь представьте, что на сайте таких страниц сотни… Результат — понижение в поиске, бесполезная трата ресурсов на продвижение. - Нет мобильной версии или верстка не адаптивная.

И Яндекс, и Гугл очень трепетно относятся к удобству пользователей. Поэтому если сайт не «мобайл-френдли», то он может быть понижен в поиске (в т.ч. и для ПК).

Наиболее распространенные ошибки seo-оптимизации страниц:

- Игнорирование метатегов.

Практически на всех сайтах, с которыми работал, тайтлы и дескрипшины не были настроены для продвижения. Часто тайтлы были одинаковыми для множества страниц или сгенерированы движком сайта.

Для информационных порталов, сделанных на популярных блоговых движках (например на Вордпрессе) эта проблема не столь актуальна, т.к. там обычно тайтл генерируется из названия материала и названия сайта, а дескрипшн просто берется из текста страницы. Обычно этого хватает, чтобы поднять видимость для низкочастотных запросов и трафик так или иначе будет идти. Но для коммерческих сайтов такая ситуация не допустима.В коммерции тайтлы и дескрипшины в обязательном порядке либо должны быть сделаны вручную, либо сгенерированы по очень продуманному шаблону.

- Чрезмерная оптимизация.

Это когда владелец сайта или не опытный сеошник пытаются всеми силами увеличить релевантность страниц. В ход идут:- выделения стронгом всех вхождений ключевиков;

- многократные повторения ключевых слов;

- прописывание одинаковых запросов в метатегах, альтах картинок, подписях к ссылкам и т.д.

Результаты, как правило, плачевные.

Чтобы избежать такой беды, нужно во всем знать меру, а при написании текстов забыть вообще про ключевые фразы.

Если вас уже накрыл фильтр за переоптимизацию, то поможет только полное изменение контента (и возможно структуры страницы). Убираете по максимуму спамные вхождения (альты картинок, метатеги, элементы меню), переписываете текст, отправляете страницы на переиндексацию и ждете. - Спамная перелинковка.

Это такой частный случай переоптимизации, когда для нагона релевантности создают блоки со ссылками на внутренние страницы с одинаковыми или похожими анкорами.

Отличить спамную перелинковку от нормальной достаточно просто. Стоит только честно ответить самому себе на вопрос: «А нужна ли тут эта ссылка (или ссылки)?» Если ответ отрицательный, смело удаляйте.

Самые распространенные проблемы с контентом сайтов:

- Мало текста.

Часто вижу сайты, у которых на посадочных страницах почти нет текста, а запросы подразумевают его наличие. Получается, что странице просто неоткуда взять релевантность. Результат виден по позициям в поиске и по трафику.

Исправляется это только одним способом. надо добавлять контент. - Много текста.

А это противоположная крайность, когда на страницах в коммерческих тематиках висят длинные описания. Очень часто эта проблема соседствует с чрезмерной оптимизацией.

Лечение простое — все лишнее долой! В коммерции тексты должны быть короткими, понятными и информативными. В некоторых случаях – умеренно эмоциональными. - Ошибки.

Да, такое тоже встречается и довольно часто. Грамматические ошибки, пунктуация, стилистика… Все это поисковики фиксируют и оценивают «по достоинству».

Тут нужно просто вычитывать тексты перед размещением.

Вот такие ошибки и проблемы мне встречаются чаще всего. Большинство из них абсолютно очевидные, но тем не менее вебмастера регулярно про них забывают.

Если у вас остались (или появились) вопросы по данной теме, буду рад ответить на них в комментариях. 🙂

Внимание!

Все материалы, размещенные на сайте, защищены законодательством РФ (Гражданский кодекс РФ, Часть четвертая).

Копирование запрещено.

Частичное цитирование статей возможно только с обязательным указанием источника в виде активной ссылки.

Использование материалов сайта без согласия правообладателей может повлечь за собой взыскание компенсации в размере от 10 000 руб до 5 000 000 руб за каждый факт нарушения (ГК РФ Статья 1301), а также штраф до 200 000 руб либо лишение свободы сроком до 2 лет (УК РФ Статья 146).